[CS224n] Lecture 4. Word window classification and neural networks

[CS224n] Lecture 4. Word window classification and neural networks

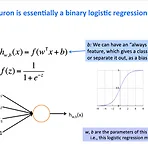

이번 수업에서는 거의 본격 neural network 해부 수업?! 간단하게 Word window 를 이용해서 해당 단어가 Named entity 인지 아닌지를 classify 하는 모델을 통해서 neural net 에서는 어떤 식으로 parameters 가 업데이트 되는지를 살펴봤다. 이번 수업을 통해서 좀 더 확실히 뉴럴넷이 back propagation 과 forward propagation 으로 이루어지는지 조금 더 잘 이해할 수 있게 됐다고나 할까?! 이번 강의 포인트 러닝 모델의 수식은 거의 항상 매트릭스를 기준으로 표현된다. 인덱스를 사용하지 않아도 돼서 간단하게 표현 가능하기 때문! 이번 수업에서는 Matrix 와 그 안의 elements 를 넘나들며 이해함! Matrix 로 표현하는 게 ..

[CS224n] Lecture 3. More word vectors

[CS224n] Lecture 3. More word vectors

1. Word2vec 의 원리 Word2vec 은 결국 window 를 옮겨가며 center word 를 가지고 context words 를 output 하는 모델을 가지고 만든다. 예를 들어 "I like deep learning and NLP" 라는 문장이 있고, window size 는 2라고 하자. 현재의 time step (t) 에서 center word 가 "deep" 일 때 를 계산하고 context words vector 와 center word vector (deep) 을 update 하는 것이다. 그 다음 time step t+1 에서는 center word 가 learning 이 되겠고, 똑같은 방식으로 window 를 옮겨가면서 실제로 함께 co-occur 하는 단어관의 확률을 높이..

[CS224n] Lecture 2. Word2vec

[CS224n] Lecture 2. Word2vec

1. NLP 에서 단어를 표현하는 방법! 의미를 표현하는 방법은 2가지가 있다. 전통적으로 쓰이는 방법과, 요새 쓰이는 방법. 1) symbolic representation = one-hot vector = localist representation (그 단어에 해당하는 곳만 1이라서 인덱스와 같이 쓰이기 때문에) 2) distributed representation 우선 symbolic 한 방법은 기존에 쓰이던 방법으로, one-hot vector 를 이용해서 원하는 단어를 표현하던 방법이다. one-hot vector 의 문제점은 여러가지가 있는데, 우선 vector 의 사이즈가 vocabulary 의 사이즈이기 때문에 vocabulary 가 늘어날 수록 사이즈가 커질 수밖에 없다. 무엇보다도 on..

- Total

- Today

- Yesterday

- LM

- language model

- Pre-trained LM

- 언어모델

- weight vector

- Neural Language Model

- 뉴럴넷

- Statistical Language Model

- word embedding

- nlp

- 뉴런

- Elmo

- cs224n

- transformer

- GPTZero

- 벡터

- neurone

- Attention Mechanism

- 워터마킹

- neural network

- Contextual Embedding

- Bert

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |